Wie gut ist ChatGPT als Mathe-Coach?

Teil 1: Textaufgaben

In diesem Beitrag möchte ich zwei Versionen von ChatGPT, nämlich die kostenlose Version 3.5 und die kostenpflichtige Version 4 daraufhin überprüfen, wie gut sie geeignet sind, Schülern beim Mathelernen zu helfen.

Diese Untersuchung erfolgt auch vor dem Hintergrund der Überlegung, einen intelligenten Chatbot in unsere Lernplattform Mathegym (https://mathegym.de) zu integrieren. Dieser könnte z.B. genutzt werden, um sich Teile einer Lösung noch genauer erklären zu lassen. Oder er denkt sich auf Anfrage weitere Aufgaben aus und lässt den Nutzer diese dann Schritt für Schritt bearbeiten, mit Rückmeldung nach jedem Einzelschritt.

Unsere mehrfach prämierte Lernplattform Mathegym wird von Schülern wie von Didaktikern vor allem deshalb geschätzt, da komplexe Aufgaben Schritt für Schritt bearbeitet werden können (siehe Bild oben). Diese Aufgaben samt ihrer Lösungsschritte und Zwischenabfragen produzieren wir manuell, somit können wir aus Kostengründen pro Aufgabentyp immer nur eine begrenzte Anzahl von Aufgaben zur Verfügung stellen. Eine weitere Beschränkung ergibt sich bei der Gestaltung der Lösungsschritte. Hier wählen wir einen Mittelweg, d.h. die Lösungen bei Mathegym sind zwar relativ ausführlich, aber für nicht so gute Matheschüler und -schülerinnen manchmal nicht ausführlich genug. Vor allem bei Lücken im Grundwissen besteht oft der Wunsch, sich einen Einzelschritt noch viel genauer erklären zu lassen. Im Einsatz von KI sehen wir also eine große Chance, solche und weitere Beschränkungen zu überwinden.

Die Frage ist nur: wie intelligent ist ChatGPT im Fach Mathe? Wir haben den Chatbot für unseren Test mit drei Textaufgaben konfrontiert. Textaufgaben gelten als Königsdisziplin, da ihre Lösung weitaus mehr erfordert als das Beherrschen eines bestimmten Algorithmus. Hier sind vor allem Textverständnis und Heuristik (wie kann ich vorgehen) notwendig – erst dann geht es ans Rechnen. Wir starten mit einer Aufgabe vom Typ „Rätsel“.

Wow! Wie man sieht, geht GPT-3,5 diese Aufgabe völlig richtig an. Auch der Rest der Lösung, den wir hier nicht abbilden, ist zu 100% korrekt und übersichtlich dargestellt. Das gleiche gilt für GPT-4.

Ok, schalten wir einen Gang hoch und konfrontieren die KI mit einer praktischen Frage, vor der Spieler des Würfelspiels Kniffel oftmals stehen.

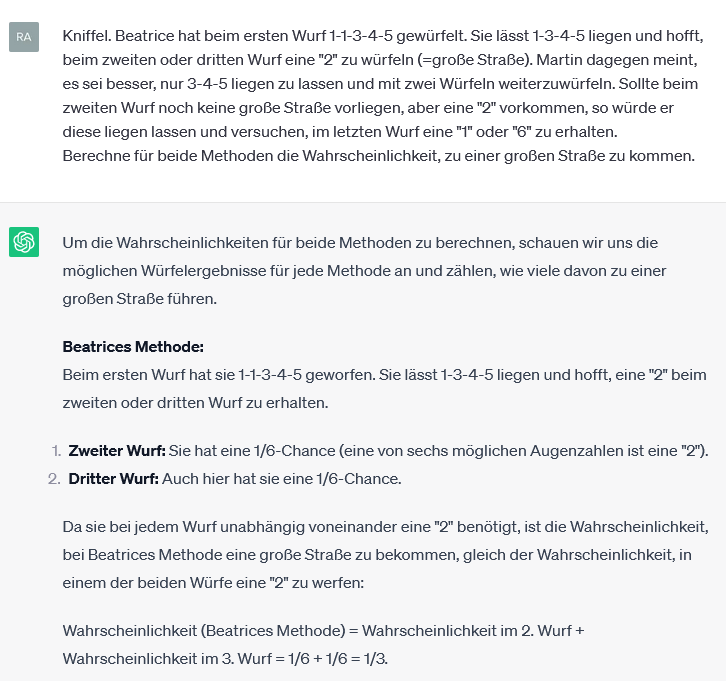

Hier stößt die Version 3,5 offenbar an ihre Grenzen. Klar, bei Beatrices Methode muss man die beiden Möglichkeiten in Erwägung ziehen, beim zweiten oder dritten Wurf eine 6 zu würfeln und die Wahrscheinlichkeiten dafür sind jeweils 1/6. Soweit richtig. Aber diese dann einfach zu addieren und das Ergebnis als ihre Gewinnwahrscheinlichkeit zu verkaufen ist natürlich viel zu schlicht gedacht. Wenn GTP-3,5 hier bereits patzt, brauchen wir uns den zweiten und wesentlich komplexeren Teil der Aufgabe, also Martins Strategie, gar nicht erst anzusehen. Schauen wir uns lieber an, wie sich die kostenpflichtige Nachfolgeversion GPT-4 bei dieser Aufgabe schlägt:

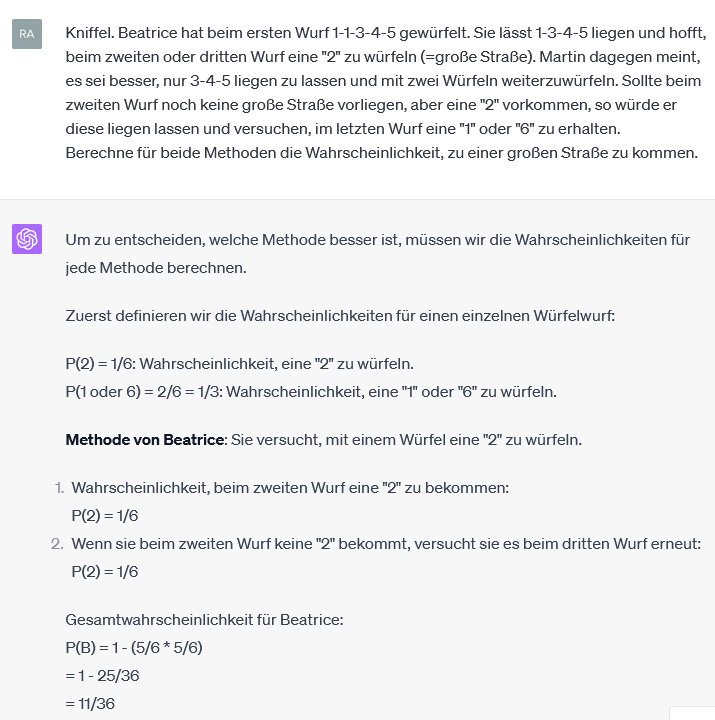

Na also, geht doch! Methode „Beatrice“ wird nun richtig berechnet. Allerdings ist die Darstellung des Lösungswegs verwirrend. Der Term 1-5/6*5/6 erscheint völlig unvermittelt. Es müsste doch erklärt werden, dass es hier um das Gegenereignis von „zweimal hintereinander keine 2“ geht. Nun könnte man natürlich als Nutzer nachhaken und sich den Term erklären lassen. Wir werden an späterer Stelle die spezielle Kompetenz, Nachfragen zufriedenstellend zu beantworten, testen. Vorläufig belassen wir es dabei, die Berechnungen auf Richtigkeit und Nachvollziehbarkeit zu testen. Wie sieht es nun mit Martins Strategie aus?

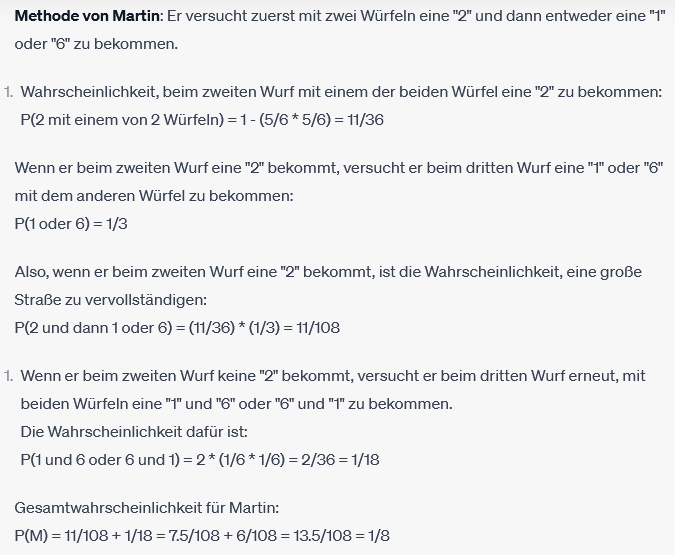

Autsch. Hier patzt GPT-4 gleich mehrmals. Es geht schon los mit der Beschreibung von Martins Methode (erste Zeile). Der Chatbot lässt die Möglichkeit, dass Martin bereits im zweiten Wurf zu einer großen Straße vollendet, völlig außer Acht. Abgesehen davon bemerkt man die Überforderung auch daran, dass zweimal die Nummerierung „1“ vergeben wird. Was unter dem zweiten mit „1“ nummerierten Absatz berechnet wird, ergibt dann überhaupt keinen Sinn mehr.

Zugegeben: fies an der Aufgabenstellung ist, dass sie ein gewisses Spielverständnis voraussetzt. Es wird nicht explizit gesagt, dass Martin sein Ziel bereits erreicht hat, wenn er im zweiten Wurf zur großen Straße ergänzt. Wer jemals Kniffel gespielt hat, muss darauf zwar nicht hingewiesen werden, aber für GTP-4 wäre ein entsprechender Hinweis wohl sehr hilfreich gewesen.

Betrachten wir daher zum Abschluss eine Textaufgabe, bei der keine derartigen Kontext-Kenntnisse für die richtige Lösung nötig sind. Eine Aufgabe, die sich kurz und knackig formulieren lässt, und die dennoch von vielen Schülern und sogar Lehrern oft falsch gelöst wird (bitte vor dem Weiterlesen erst einmal selbst probieren!).

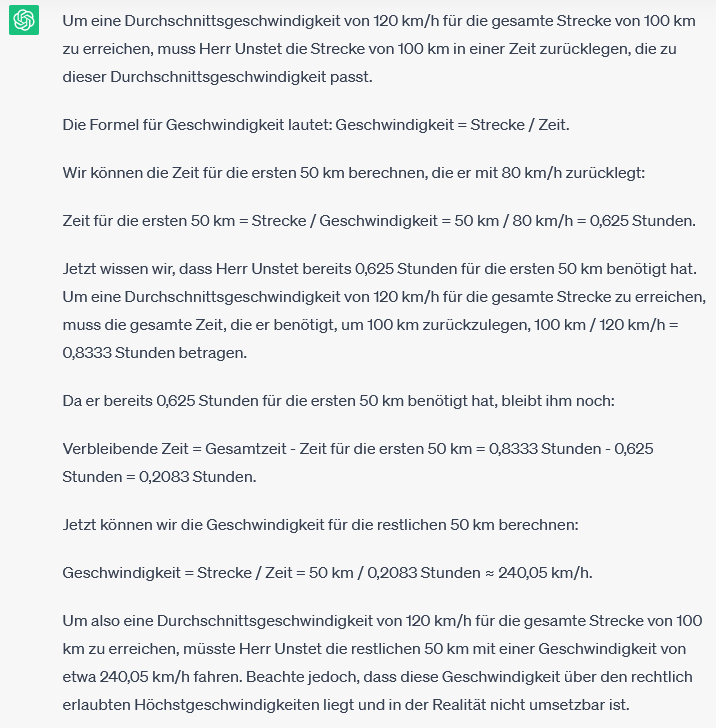

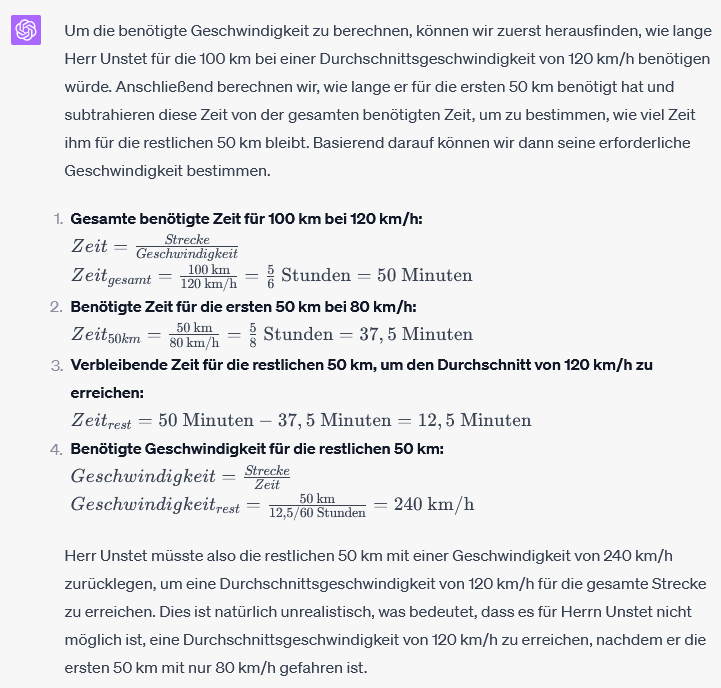

Herr Unstet legt eine 100 km lange Strecke zurück. Die ersten 50 km fährt er mit 80 km/h. Wie schnell müsste er die restlichen 50 km fahren, um auf eine Durchschnittsgeschwindigkeit von 120 km/h zu kommen?

Respekt! Beide Versionen checken die Aufgabe und wählen den richtigen Rechenweg. Tatsächlich tappen viele menschliche Rechner bei dieser Aufgabe in die Falle und antworten falsch mit „160 km/h“ gemäß der Überlegung, dass sich 120 als Mittelwert aus 80 und 160 ergibt.

Im direkten Versionvergleich fällt natürlich sofort auf, dass die Lösung in der kostenpflichtigen Version viel übersichtlicher strukturiert ist. Zudem wandelt GPT-3,5 hier Brüche ungefragt in gerundete Dezimalzahlen um, weshalb dann auch das Ergebnis 240,05 km/h etwas seltsam anmutet.

Fairer Weise möchte ich erwähnen, dass GTP-4 zwei Tage zuvor, als ich diese Aufgabe bereits schon einmal stellte, sich bei einem recht simplen Zwischenschritt einen groben Fehler erlaubt hat und daher auf ein ganz falsches Ergebnis „200 km/h“ kam: die KI rechnete 12,5 Minuten in 1/4 Stunde um!

Fazit

Bei allen noch bestehenden Unzulänglichkeiten ziehe ich meinen Hut vor den Machern von GPT-4, insbesondere vor der Arbeitsgruppe, die dem IT-Chatbot reichlich Mathekompetenz hinzugefügt hat. Meines Wissens hat GPT-4 im Vergleich zur Vorgängerversion eine Menge neuer „algebra prompts“ erhalten, die, sobald eine Textaufgabe auf der sprachlichen Ebene analysiert ist, ins Spiel kommen und exakte Lösungen auf der Grundlage mathematischer Rechenverfahren ermöglichen.

Dennoch kann selbst GPT-4 als Mathe-Tutor für Textaufgaben nur eingeschränkt empfohlen werden. Wer bei einer sachbezogenen Aufgabe nicht weiterkommt, sollte die Ausführungen von GPT lediglich als Vorschlag verstehen. Kompetente Matheschüler werden selbst aus fehlerhaften Lösungen einen Nutzen ziehen, da sie die richtigen Lösungsparts als Impuls verwerten und die falschen als solche entlarven und selbstständig richtigstellen können. Je leistungsschwächer Schülerinnen und Schüler dagegen sind, desto mehr besteht die Gefahr, dass sie falsche Lösungen von GPT unhinterfragt übernehmen und somit falsche Konzepte erwerben oder, wenn sie denn über Widersprüche stolpern, verwirrt und verunsichert zurückbleiben.

In Kombination mit einem menschlichen Tutor oder Lehrer, der bei Bedarf hinzugezogen werden kann, ist die Verwendung von GPT zum Erklärenlassen und Üben von Textaufgaben dagegen auf jeden Fall sinnvoll.